分类模型:输出变量为分类型的分类预测模型;

回归模型:输出变量为连续数值型的分类预测模型。

经典案例:电信客户流失、药物研究

决策树(Decision Tree)模型也称规则推理模型、判定树模型,其分析结论展示类似一棵倒置的树,为分类预测算法之一。

目标:建立分类模型或回归模型。

属于有指导(监督)式的学习方法,有两类变量:目标变量(输出变量)和属性变量(输入变量)

多叉树:长出不止两个分枝,即父节点有两个以上子节点。

决策树体现了对样本不断分组的过程;

决策树分为分类树和回归树;

决策树体现了输入变量和输出变量的取值之间的逻辑关系。最大特点:其分类预测是基于逻辑的。

方便理解:构造简单,表示方法直观,易于理解,可表示成If Then形式。

准确性高:挖掘出的分类规则准确性高,可清晰显示哪些字段重要。

数据属性多样:能够同时处理数据型和常规型属性。

计算量小:计算量相对来说不是很大,且容易转化成分类规则。

数据准备简单:对于决策树,数据的准备往往是简单或者是不必要的。其他的技术往往要求先把数据一般化,比如去掉多余的或者空白的属性。

白盒模型:若给定一个观察的模型,则根据所产生的决策树很容易推出相应的逻辑表达式。

易于评测:易于通过静态测试来对模型进行评测。表示有可能测量该模型的可信度。

速度快:在相对短的时间内能够对大型数据源做出可行且效果良好的结果。

效率高:决策树只需要一次构建,反复使用,每一次预测的最大计算次数不超过决策树的深度。

缺乏伸缩性:由于进行的是深度优化搜索,故算法受内存大小限制,难于处理大训练集。

连续性的字段比较难预测,当类别较多时,错误可能会增加的比较快。一般算法在分类时,只是根据一个属性来分类。

在有噪声时,完全拟合将导致过分拟合,导致预测性能不好。

可能产生子树复制和碎片问题。

决策树几何理解:

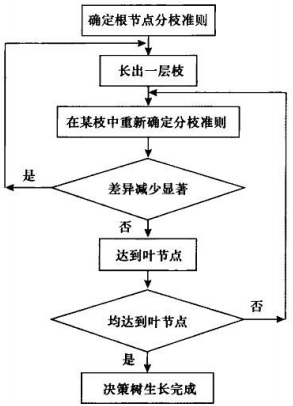

建树:用训练样本集完成决策树的建立过程;

剪枝:用测试样本集对所形成的决策树进行精简。

图1 决策树生长过程的示意图

如何从众多输入变量中选择一个当前最佳的分组变量;

如何从分组变量的众多取值中找到一个最佳的分割点。

事先指定决策树生长的最大深度,决策树生长到指定深度后就不再生长;

事先指定样本量的最小值,节点样本量不应低于该值,否则不再生长。

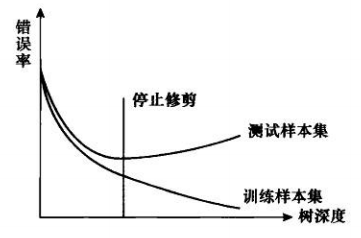

待决策树充分生长后,根据一定规则,剪去决策树中不具代表性的子树,边修剪边检验。

事先指定一个允许的最大误差,修剪过程不断计算当前决策子树对输出变量的预测误差,高于允许最大误差时,停止剪枝,否则继续。

图2 决策树的修剪

图2 中,生长初期,决策树在训练和测试样本集上的预测误差快速减少。随着树深度的增加,预测误差减少速度开始放缓。当树达到一定深度后,训练样本集上的误差仍继续减少,但在测试样本集上开始增大,出现过拟合。后剪枝应停止在预测误差较小且过拟合未出现时。

参考文献:

2、算法杂货铺——分类算法之决策树(Decision tree)

4、维基百科:决策树

—————————————————————————

【版权申明】

如非注明,本站文章均为 数据小雄 原创,转载请注明出处:数据小雄博客,并附带本文链接,谢谢合作!

本文地址:http://zhangzhengxiong.com/?id=74。

—————————————————————————

流泪

1人

打酱油

2人

开心

2人

鼓掌

0人

恐怖

0人

发表评论

额 本文暂时没人评论 来添加一个吧